728x90

[LLM] LM Studio

LM Studio는 컴퓨터에서 로컬 LLM을 실행하기 위한 데스크톱 애플리케이션이다.

localhost에서 실행되는 API 서버를 통해 LM Studio 내에서 로드한 LLM을 사용할 수 있다.

요청과 응답은 OpenAI의 API 형식을 따르며,

현재 OpenAI를 사용하는 코드가 localhost:PORT 대신 로컬 LLM을 사용하도록 지정한다.

지원하는 Endpoint

GET /v1/models

POST /v1/chat/completions

POST /v1/embeddings

POST /v1/completions

로컬 서버 구성

1. 공식 홈페이지에서 OS에 맞는 LM Studio를 설치한다.

👾 LM Studio - Discover and run local LLMs

Find, download, and experiment with local LLMs

lmstudio.ai

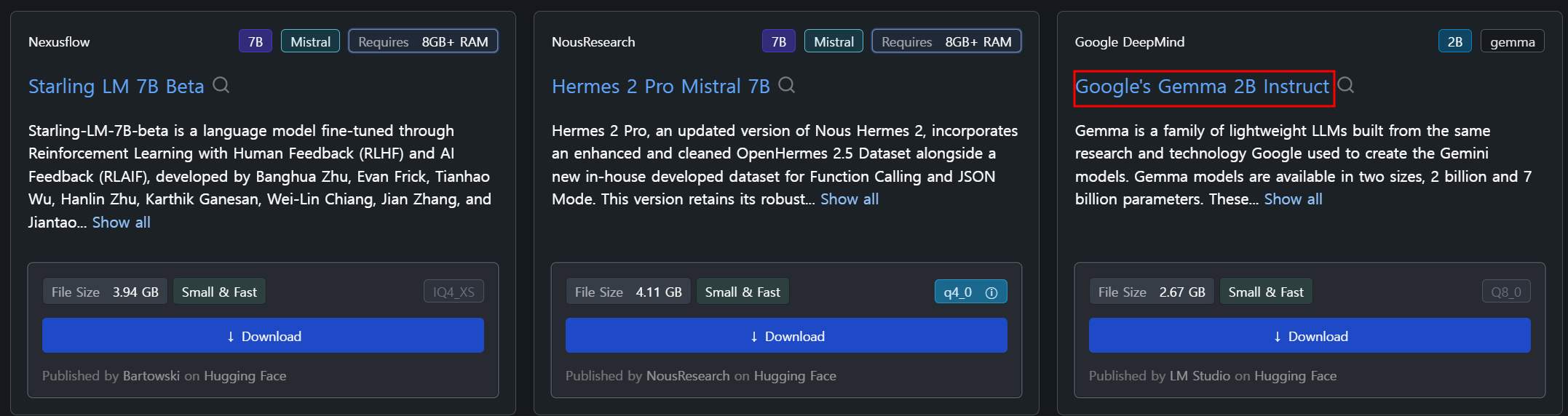

2. 앱 내에서 TheBloke/Mistral-7B-Instruct-v0.2-GGUF 와 같은 LLM을 검색하고 다운로드한다.

나는 테스트용으로 홈 화면에 Gemma의 경량 모델을 설치했다.

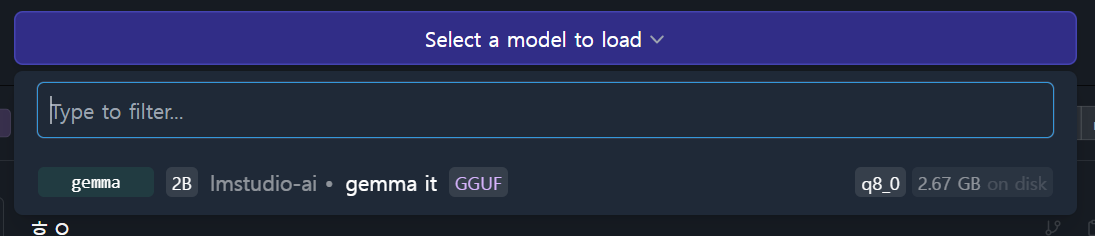

3. 로컬 서버 탭으로 이동한다.

4. 다운로드한 LLM을 로드한다.

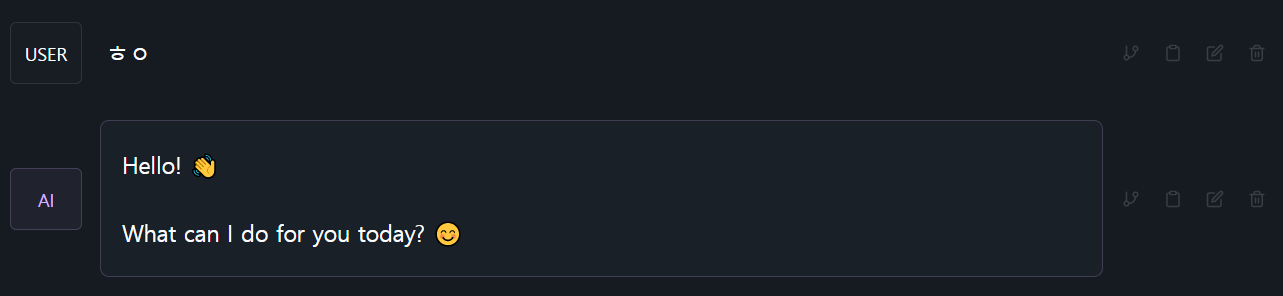

5. 서버 시작 버튼을 클릭하여 서버를 시작한다.

참고

반응형

'🤖 AI > LLM' 카테고리의 다른 글

| [LLM] RAG (Retrieval-Augmented Generation) (0) | 2024.07.03 |

|---|---|

| [LLM] 올라마 모델에 랭체인 적용하기 (0) | 2024.06.27 |

| [LLM] 랭체인(LangChain) (0) | 2024.06.24 |

| [LLM] 올라마(Ollama) (0) | 2024.06.21 |

| [LLM] 프롬프트 엔지니어링 (0) | 2024.06.13 |